Twilio Protocolsの仕組み

Protocolsを使用することで、複数のワークフローとプロセスを自動化し、クリーンで一貫性のある顧客データを大規模に保守できます。

-

共有データ辞書の作成

時代遅れのスプレッドシートを置き換え、社内のチームを適切に設計されたトラッキングプランに適合させます。

-

品質の問題を診断

QAプロセスを自動化し、常にデータ品質違反を検出します。トラッキングコードを手動でテストすることによる時間の無駄がありません。

-

データの信頼性の維持

不適合イベントをブロックする厳格な管理によりデータ標準を徹底し、さらに長期的に高品質のデータを確保することで、データに自信が持てるようになります。

データの整合性を最大限に活用

実証済みのベストプラクティスで顧客データを保護します。

Protocolsの機能

データ品質管理を拡張するツールにアクセスできます。

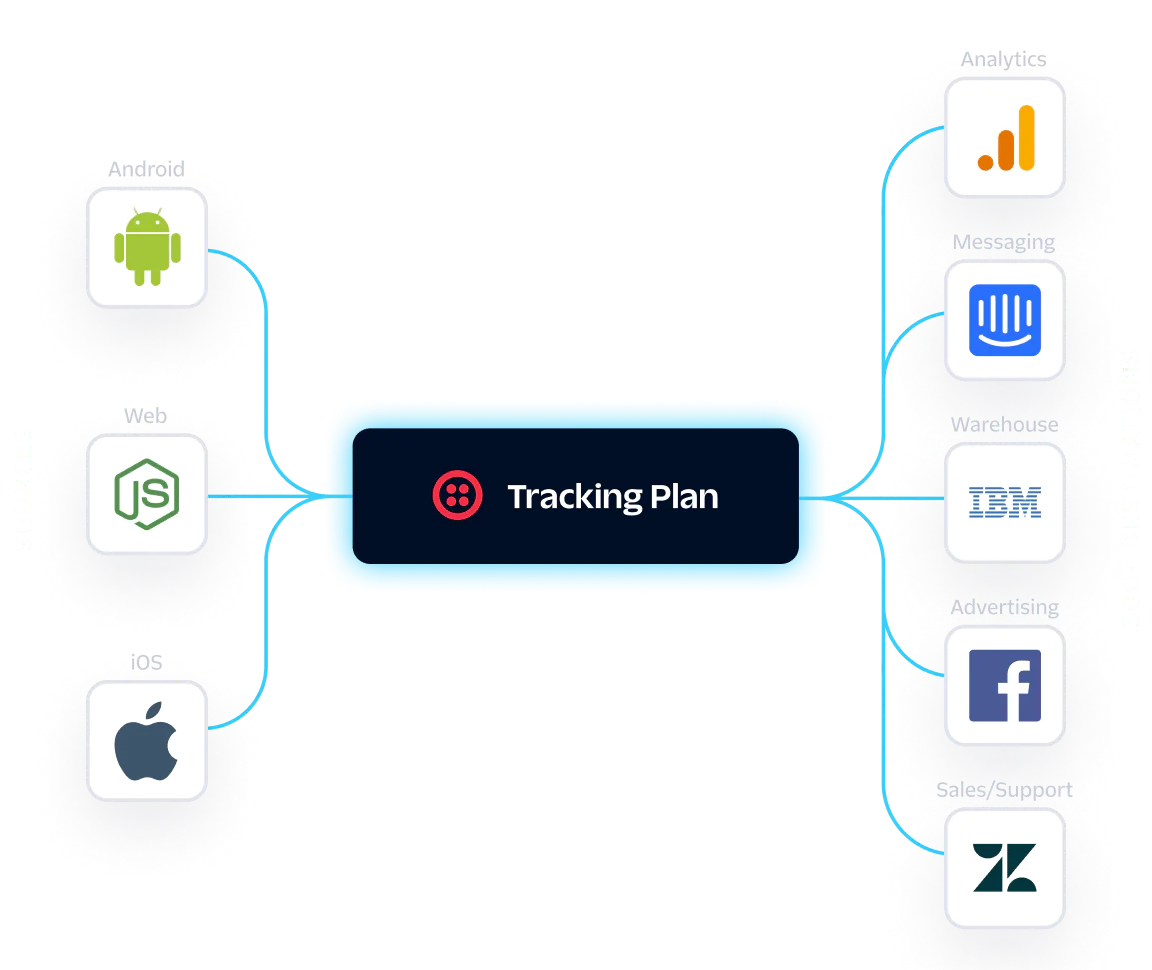

すべての顧客データを接続

すべてのファーストパーティデータを単一のプラットフォームで収集、統合、アクティブ化することで、クリーンで一貫性のあるデータを簡単に保守できます。

-

時代遅れのスプレッドシートを、ソースから収集するイベントとプロパティの概要を示すデータ仕様に置き換えます。

-

接続されているすべてのソースからの不適合イベントを1か所でレビュー、解決、転送します。

-

スキーマを設定して、ソースのイベント、プロパティ、および特性を選択的にブロックさせるか、CDPを通過しないようにします。

-

トラッキングプランに基づいて強い型付けをされた分析ライブラリを生成し、実装エラーを削減します。

-

変換を適用して、ダウンストリームの宛先に送信されるデータを完全に管理します。

-

アプリ内レポートと毎日の電子メールダイジェスト

チームが誤って不良データを使用して決定を下す前に、あらゆる無効なイベントについて、迅速に対処するのに必要な情報を入手します。

-

イベント量の異常の発生または違反のカウントが始まると、通知を受信します。データ収集が機能しくなり、欠落し、または不正確になったのが何時か分かります。

-

パブリックAPIを使用して、顧客データの収集と活用に関するワークフローを拡張できます。

データガバナンスの自動化を開始し、規模が急速に拡大するのをご覧ください

Protocolsを始めるのに役立つドキュメント、オンラインコースなどをご覧ください。

Protocolsの設定にヘルプが必要ですか?

信頼できるパートナーの協力のもと、データガバナンスソリューションを設定し、データ品質管理の自動化を開始できます。 パートナーを表示

データ品質の管理は簡単です

Protocolsがいかにデータの信頼性を向上させ、検証に費やす時間を短縮し、最終的にはビジネスの成長を加速させるかをご確認ください。

FAQ

データクレンジングとは、データの完全性、正確性、信頼性を確保して、分析、意思決定、レポート作成に使用できるようにするプロセスです。データクレンジングには、古くなった情報や不足している情報の修正、データエントリへの標準化された命名規則の適用による一貫性の確保、イベントの重複排除、透明性のためのデータ変換の記録などが含まれます。

データを適切にクリーニングしないと、組織は、不正確な、または誤解を招く情報を基に戦略やキャンペーンを立てるリスクにさらされます。重複したデータエントリ、不完全なフィールド、一貫性のない命名規則が、「不良データ」の背後にあるよくある原因です。この不良データにより的外れなインサイトや誤った意思決定が導かれ、企業は毎年何百万ドルもの損失を出しています。

強力なデータ基盤を構築するには、取り込むデータの優先順位の付け方、命名規則、プライバシーを尊重してデータ収集をプロアクティブに調整することに細心の注意を払う必要があります。そのための最初のステップは、成果に結びつくデータの特定を、組織がCDPにより達成しようとするビジネス目標に基づいて行うことです。CDPを使用して有意義なデータを追跡する場合は、まずこれらの目標を定義する必要があります。

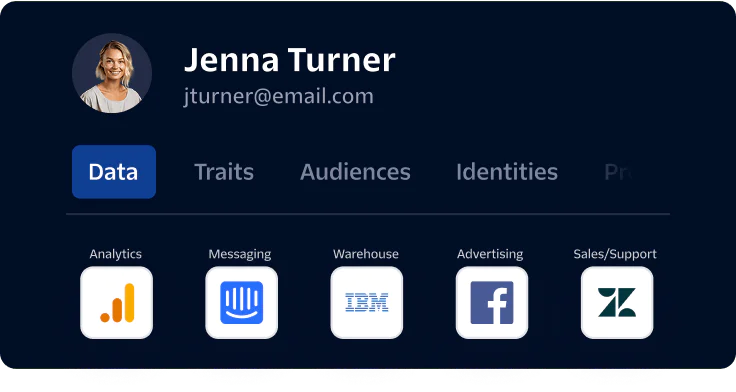

成果と結びつく測定すべきイベントを特定したら、それを活用してトラッキングプランを作成できます。トラッキングプランにより、どのデータが重要か、どこで追跡するのか、なぜトラッキングするのかについての一貫したロードマップが提供されます。トラッキングプランを中心とした人とプロセスの調整についての詳しい解説については、『顧客データ成熟度ガイド』を参照することをお勧めします。